Was bedeutet Indexierung bei Google?

Autor: Alex Rodionov

Wer eine Website betreibt, hat sicher schon von der Indexierung bei Google gehört – doch was bedeutet sie im Detail und welche Stellschrauben könnt Ihr drehen, um Eure Sichtbarkeit zu erhöhen? Die Indexierung ist der Prozess, bei dem Google Eure Inhalte aufnimmt und im Google Index ablegt. Nur so können Nutzer Eure Seiten über Suchanfragen finden. In diesem umfassenden Guide beleuchten wir alle Phasen – vom ersten Aufruf durch den Googlebot bis hin zu den Algorithmen, die über Relevanz und Aktualität entscheiden.

1. Discovery & Crawling: Der erste Kontakt

Bevor Google Eure Seiten indexiert, muss es sie zuerst entdecken. Googlebot folgt internen Links, externen Verweisen und Vorschlägen aus der XML-Sitemap. Je besser Ihr diese Elemente optimiert, desto schneller gelangen neue oder aktualisierte URLs in den Crawl-Plan:- XML-Sitemap: Achtet darauf, nur indexierbare URLs einzutragen und regelmäßig zu aktualisieren.

- robots.txt: Verzichtet auf wildes Sperren ganzer Verzeichnisse – testet mit dem „robots.txt-Tester“ in der Search Console.

- Interne Verlinkung: Verbindet thematisch verwandte Artikel mit Breadcrumbs oder „Weiterlesen“-Hinweisen, damit auch tieferliegende Seiten gut erreichbar sind.

- Crawl-Budget: Große Portale sollten unnötige Parameter-URLs ausschließen, damit der Googlebot sein Kontingent auf wichtige Seiten konzentriert.

2. Rendering & Parsing: Inhalte sichtbar machen

Googlebot analysiert beim Crawling nicht nur das reine HTML, sondern rendert auch JavaScript, um dynamisch nachgeladene Inhalte zu erfassen. Folgende Aspekte sind entscheidend:- HTML-Grundstruktur: Überschriften (H1–H6), Absätze, Lists und Meta-Tags geben Google Orientierung.

- JavaScript-Frameworks: React, Vue oder Angular können Inhalte dynamisch laden – testet mit dem „URL-Prüftool“, ob alles sichtbar wird.

- Strukturierte Daten: Mit JSON-LD-Markup aktiviert Ihr Rich Snippets (z. B. FAQs, Breadcrumbs oder Produktinfos).

- Medien-Assets: Bilder mit Alt-Text, eingebettete Videos und Tabellen sollten suchmaschinenfreundlich aufbereitet sein.

3. Die Rolle der Algorithmen im Indexierungsprozess

Google nutzt eine Vielzahl von Algorithmen, um den Google Index aktuell und qualitativ hochwertig zu halten. Die wichtigsten im Überblick:- Freshness-Algorithmus: Belohnt neue oder kürzlich aktualisierte Inhalte, besonders bei News, Events und zeitkritischen Themen.

- Canonicalization: Verhindert Duplicate Content, indem eine kanonische URL festgelegt wird.

- Mobile-First-Indexing: Bewertet vor allem die mobile Version Eurer Seiten – responsive Design ist Pflicht.

- Page Experience: Core Web Vitals wie Ladezeit (LCP), Interaktivität (FID) und Stabilität (CLS) fließen ins Ranking ein.

- Semantic Understanding: NLP-Modelle wie BERT verstehen den Kontext und die Semantik Eures Textes.

4. Architektur des Google Index

Man kann sich den Google Index als dreistufigen Speicher vorstellen:- Caffeine Layer: Schnellere Updates für tagesaktuelle Inhalte.

- Core Layer: Dauerhaft relevante Seiten mit hoher Autorität.

- Supplemental Layer: Weniger wichtige oder selten besuchte URLs.

5. Typische Fallen und wie Ihr sie umgeht

Selbst erfahrene Webmaster stolpern manchmal über dieselben Probleme:- Falsche Redirects: Verwendet 301 statt 302 und meidet Redirect-Chains.

- JavaScript-Blocker: Testet, ob Euer JS-Framework von Googlebot ausgeführt wird.

- Noindex-Fehler: Ein versehentliches Meta-Robots-Tag kann Seiten unsichtbar machen.

- Duplicate Content: Nutzt konsequent Canonical-Tags oder 301-Weiterleitungen.

- Crawl-Fehler: 404-Statuscodes oder Server-Time-Outs verhindern die Indexierung bei Google.

6. Best Practices für eine saubere Indexierung bei Google

Mit diesen Maßnahmen stellt Ihr sicher, dass Eure wichtigsten Seiten zuverlässig im Index landen:- robots.txt & Meta-Robots prüfen in der Search Console.

- XML-Sitemaps aktuell halten und nur relevante URLs listen.

- Responsive Design und Mobile-First-Tests durchführen.

- Schema.org-Markup gezielt einsetzen – eine professionelle SEO-Beratung kann dabei helfen.

- Crawl-Budget steuern durch Ausschluss von Tracking-Parametern.

- Content-Qualität sicherstellen und regelmäßige Updates planen.

7. Monitoring & Tools

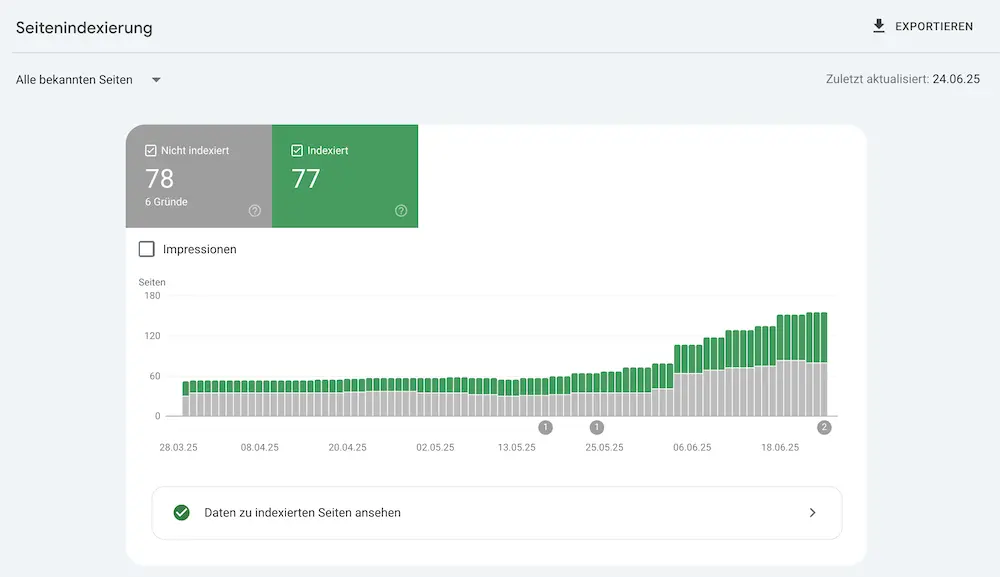

Behaltet Eure Indexierungs-Performance im Blick:- Search Console: Abdeckungs- und Leistungsberichte.

- Screaming Frog: Simuliert den Crawl und zeigt technische Fehler.

- Log-File-Analyse: Erkennt, welche Seiten wie oft gecrawlt werden.

8. Vertiefende Themen

Viele Websites profitieren von zusätzlicher Spezialisierung:- SEO für Onlineshops: Produktseiten und Kategorien richtig indexieren – mehr dazu unter Onlineshop-SEO.

- Internationales SEO: Sprach- und Länderversionen korrekt ausliefern – siehe Internationales SEO.

9. Offizielle Quellen & weiterführende Links

Alle Details rund um Crawling und Indexierung findet Ihr in der offiziellen Google-Dokumentation: Google Developers – Crawling & Indexierung.10. Fazit und nächste Schritte

Die Indexierung bei Google bildet das Fundament jeder erfolgreichen SEO-Strategie. Stellt sicher, dass Eure wertvollsten Seiten korrekt gecrawlt, gerendert und schließlich im Google Index abgelegt werden. Mit einer sauberen Sitemap, klarem Aufbau, technischem Monitoring und gezieltem Einsatz strukturierter Daten bleibt Ihr dauerhaft sichtbar. 👉 Prüft heute Eure Search Console, behebt mögliche Blockierungen und optimiert Eure Seiten für bestmögliche Indexierungsraten! 🚀Empfohlenes YouTube-Video zum Thema (auf Englisch):

Die neusten Artikel im Blog lesen:

Online Marketing Wissen

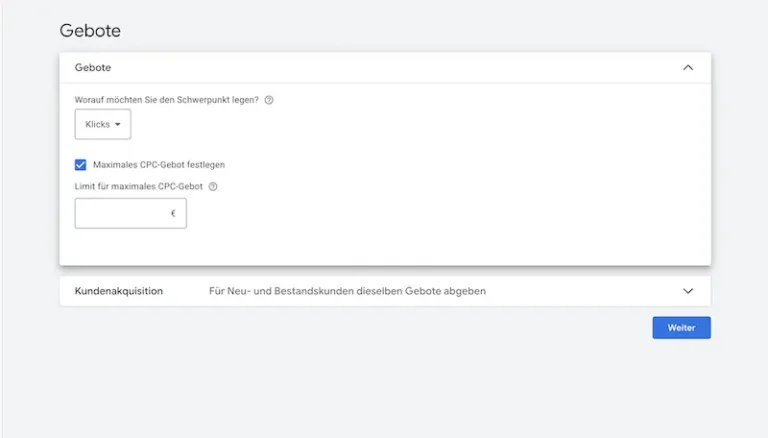

Klicks maximieren bei Google Ads. Strategie, Einsatz & Tipps

Klicks maximieren ist eine Google Ads Gebotsstrategie, die auf möglichst viele Klicks abzielt. Erfahrt, wann sie sinnvoll ist und wie Ihr sie korrekt einsetzt

Februar 12, 2026

Online Marketing News

Online Marketing News Februar 2026

Februar 2026 bringt Bewegung in KI, Werbung und Suche: ChatGPT Ads, personalisierte KI-Antworten, Google Ads Automatisierung und das Yahoo-Comeback

Februar 1, 2026

Online Marketing News

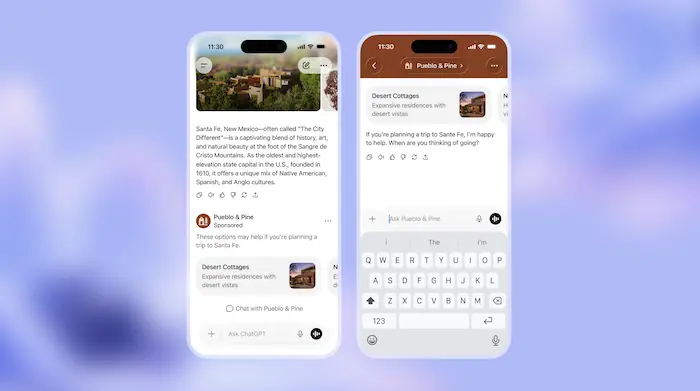

ChatGPT Werbung: Wie ChatGPT Ads das Online Marketing verändern könnten

ChatGPT Werbung steht vor dem Start: Wie ChatGPT Ads funktionieren sollen, warum hohe Budgets nötig sind und ob Werbung in ChatGPT die Zukunft wird.

Januar 26, 2026

Online Marketing News

Online Marketing News Januar 2026: Google Ads, SEO & KI

Google treibt den KI-Modus weiter voran: Neue Ads-Formate, GSC-Updates, Discovery-Entwicklungen, Shopify-Experimente und klare Aussagen zu SEO und KI.

Januar 5, 2026