Wie funktioniert der Google Crawler und das Crawlen bei Google?

Autor: Alex Rodionov

Der Google Crawler ist das zentrale Werkzeug, das Google verwendet, um das gesamte Internet zu durchsuchen und Webseiten für den Index vorzubereiten. Wer versteht, wie das Crawlen bei Google abläuft, kann gezielt seine Website-Struktur optimieren, die Sichtbarkeit steigern und sicherstellen, dass alle relevanten Inhalte indexiert werden. In diesem umfassenden Artikel erfahren Sie, wie der Crawler arbeitet, welche Faktoren das Crawling beeinflussen und welche Maßnahmen Sie ergreifen können, um effizient gecrawlt zu werden.

Beim Crawlen bei Google verfolgt der Crawler mehrere Kernaufgaben:

Beim Crawlen bei Google verfolgt der Crawler mehrere Kernaufgaben:

1. Was ist der Google Crawler?

Der Google Crawler, auch bekannt als Googlebot, ist ein automatisiertes System, das Webseiten aufruft, analysiert und deren Inhalte für den Google-Index aufbereitet. Dabei unterscheidet Google zwischen verschiedenen Varianten: Desktop-Crawler und Mobile-Crawler. Beide prüfen Seiten auf unterschiedliche technische und inhaltliche Kriterien, um eine möglichst präzise Indexierung sicherzustellen. Der Crawler folgt sowohl internen Links innerhalb Ihrer Website als auch externen Backlinks, sammelt Inhalte, analysiert die Struktur der Website und bewertet die Qualität der Informationen. Wichtige Faktoren sind Ladegeschwindigkeit, mobile Optimierung, sichere HTTPS-Verbindungen und eine klare URL-Struktur. Wer diese Punkte berücksichtigt, erhöht die Effizienz des Crawlens bei Google.2. Aufgaben und Ziele des Google Crawlers

Beim Crawlen bei Google verfolgt der Crawler mehrere Kernaufgaben:

Beim Crawlen bei Google verfolgt der Crawler mehrere Kernaufgaben:

- Seiten entdecken: Jede URL, die über interne oder externe Links erreichbar ist, wird potenziell gecrawlt.

- Inhalte analysieren: Texte, Metadaten, Bilder, Videos und strukturierte Daten werden erfasst, um die thematische Relevanz einzuschätzen.

- Indexierung vorbereiten: Inhalte, die Qualitätsrichtlinien entsprechen, gelangen in den Google-Index.

- Priorisierung: Der Crawler entscheidet anhand von Faktoren wie Domain-Popularität, Alter der Inhalte und interner Linkstruktur, welche Seiten häufiger besucht werden.

- Generative Engine Optimization (GEO): Moderne Algorithmen nutzen GEO, um Inhalte semantisch und kontextbezogen zu analysieren und priorisieren.

3. Technischer Ablauf des Crawling-Prozesses

Der Prozess beginnt in der Regel mit Seed-URLs oder eingereichten Sitemaps. Der Crawler entscheidet, welche Seiten zuerst besucht werden, basierend auf Aktualität, interner Verlinkung und Relevanz. Jede Website verfügt über ein Crawling-Budget, das angibt, wie viele Seiten pro Tag besucht werden können. Effiziente interne Strukturen, saubere URLs und aktuelle Sitemaps erhöhen die Wahrscheinlichkeit, dass alle wichtigen Inhalte indexiert werden. Praktisch bedeutet das: Wer eine flache Hierarchie mit klaren Pfaden, sprechenden URL-Strukturen und internen Verlinkungen nutzt, ermöglicht dem Crawler einen schnelleren Zugriff auf alle wichtigen Inhalte. Tools zur Überwachung des Crawlings helfen, Engpässe frühzeitig zu erkennen.4. Wichtige Faktoren für effizientes Crawling

- Servergeschwindigkeit: Schnelle Ladezeiten erhöhen die Zahl der gecrawlten Seiten.

- Mobile-First Indexing: Google bewertet vorrangig die mobile Version Ihrer Website.

- Interne Verlinkung: Klare, logische Strukturen helfen dem Crawler, alle wichtigen Inhalte zu finden.

- HTTPS: Sichere Websites werden bevorzugt indexiert.

- Fehlerfreie Seiten: 404-Fehler, Weiterleitungsketten oder blockierte Ressourcen mindern die Crawl-Effizienz.

5. Steuerung des Crawlers

Website-Betreiber können das Crawlen gezielt beeinflussen, um die Effizienz zu steigern:- robots.txt: Steuert, welche Bereiche nicht gecrawlt werden dürfen.

- Meta Robots Tags: Legt fest, ob Seiten indexiert werden und Links verfolgt werden sollen.

- Canonical Tags: Verhindern Duplicate Content, indem sie die bevorzugte URL definieren.

- Sitemaps: Unterstützen den Crawler beim Auffinden aller relevanten Seiten.

6. Häufige Probleme beim Crawlen

Typische Stolpersteine für den Crawler sind:- Duplicate Content: Gleiche Inhalte auf mehreren URLs stören die Indexierung.

- Endlose URL-Schleifen: Dynamische URLs ohne Begrenzung blockieren den Crawler.

- Blockierte Ressourcen: CSS- oder JS-Dateien, die gesperrt sind, verhindern eine vollständige Analyse.

- Selten aktualisierte Seiten: Seiten, die nicht regelmäßig gepflegt werden, verlieren an Crawling-Priorität.

7. Optimierungstipps für bessere Indexierung

- Technische OnPage-Optimierung: Sauberes HTML, schnelle Ladezeiten, strukturierte Daten und klare URLs.

- Aktualisierte XML-Sitemaps: Neue oder geänderte Seiten sollten sofort eingetragen werden.

- Content-Qualität: Originelle Inhalte mit Mehrwert erhöhen die Relevanz für den Crawler.

- Regelmäßige Updates: Aktualisierte Inhalte werden bevorzugt gecrawlt.

8. Praxisbeispiele für effizientes Crawling

- Strukturierte Daten: Schema.org Markup hilft dem Crawler, Inhalte wie Produkte, Events oder FAQs schneller zu erfassen.

- Interne Verlinkung: Durchdachte Ankertexte und eine logische Seitenhierarchie erhöhen die Priorität wichtiger Inhalte.

- Sitemap-Updates: Jede neue oder aktualisierte Seite sollte direkt in der XML-Sitemap eingetragen werden, um vom Crawler schnell gefunden zu werden.

- Regelmäßige Content-Pflege: Aktualisierte Inhalte werden bevorzugt gecrawlt, was langfristig die Sichtbarkeit erhöht.

- GEO-Optimierung: Mit Generative Engine Optimization lassen sich semantisch passende Inhalte gruppieren,

9. Fazit

Der Google Crawler ist essenziell für die Indexierung und Sichtbarkeit Ihrer Website. Wer das Crawlen bei Google versteht, kann gezielt Optimierungen durchführen, von technischen Anpassungen über Content-Qualität bis hin zu strukturierten GEO-Strategien. Durch ein ganzheitliches Vorgehen stellen Sie sicher, dass alle relevanten Seiten effizient gecrawlt und korrekt indexiert werden. Eine gut geplante Kombination aus technischer Optimierung, hochwertigem Content und Generative Engine Optimization unterstützt die Effizienz des Crawlers nachhaltig und verbessert die Chancen, in den Suchergebnissen sichtbar zu sein.Empfohlenes YouTube-Video zum Thema von Google selbst:

Die neusten Artikel im Blog lesen:

Online Marketing Wissen

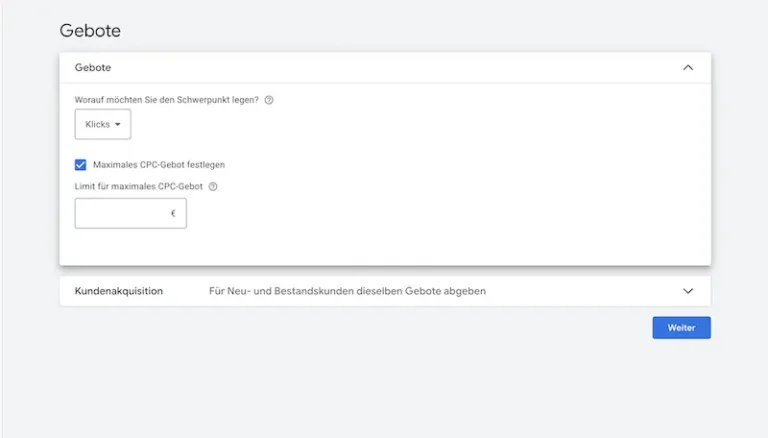

Klicks maximieren bei Google Ads. Strategie, Einsatz & Tipps

Klicks maximieren ist eine Google Ads Gebotsstrategie, die auf möglichst viele Klicks abzielt. Erfahrt, wann sie sinnvoll ist und wie Ihr sie korrekt einsetzt

Februar 12, 2026

Online Marketing News

Online Marketing News Februar 2026

Februar 2026 bringt Bewegung in KI, Werbung und Suche: ChatGPT Ads, personalisierte KI-Antworten, Google Ads Automatisierung und das Yahoo-Comeback

Februar 1, 2026

Online Marketing News

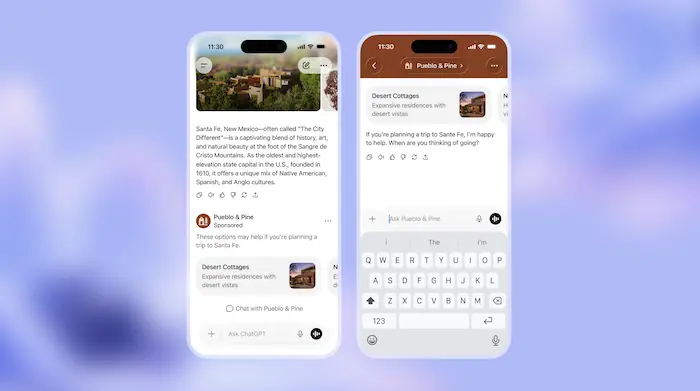

ChatGPT Werbung: Wie ChatGPT Ads das Online Marketing verändern könnten

ChatGPT Werbung steht vor dem Start: Wie ChatGPT Ads funktionieren sollen, warum hohe Budgets nötig sind und ob Werbung in ChatGPT die Zukunft wird.

Januar 26, 2026

Online Marketing News

Online Marketing News Januar 2026: Google Ads, SEO & KI

Google treibt den KI-Modus weiter voran: Neue Ads-Formate, GSC-Updates, Discovery-Entwicklungen, Shopify-Experimente und klare Aussagen zu SEO und KI.

Januar 5, 2026